【行业】人工智能芯片-GPU正红,ASIC拥抱未来(21页)

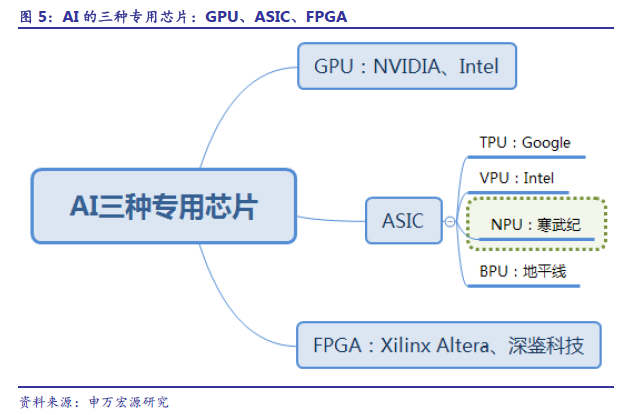

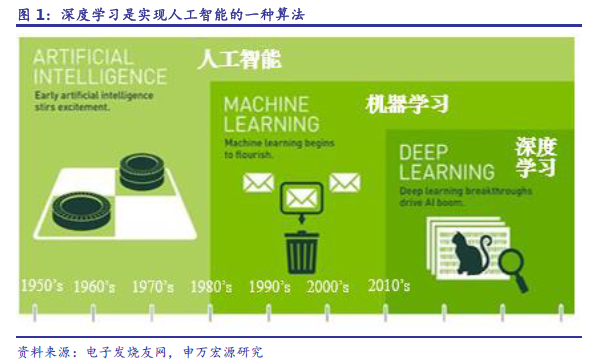

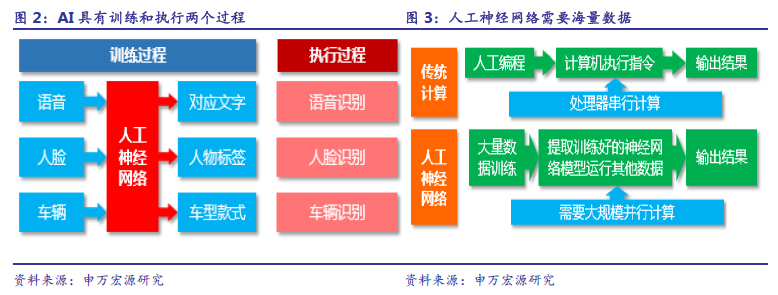

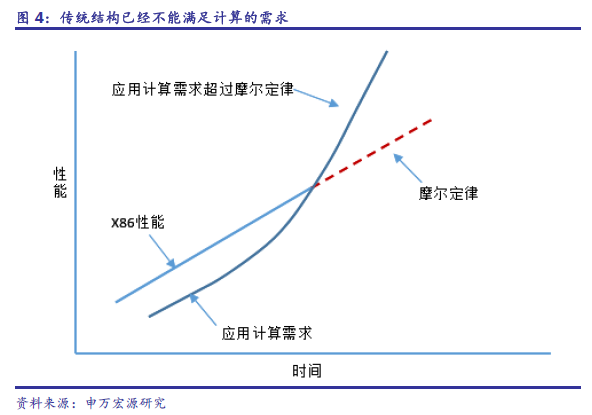

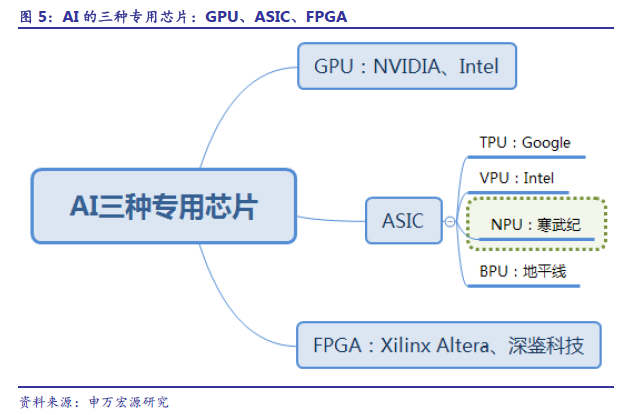

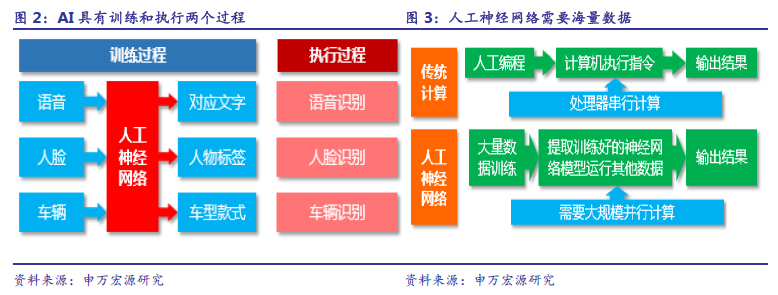

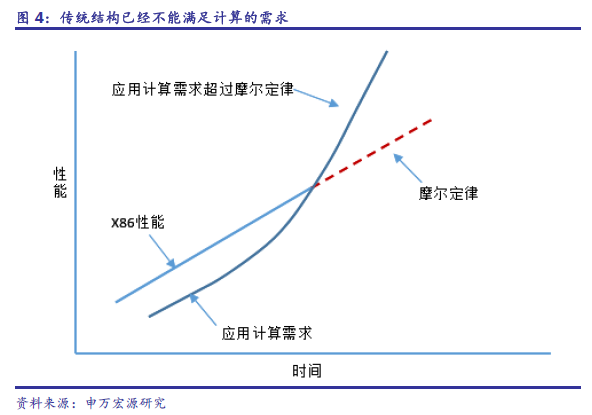

AI 加速需求超过CPU 计算能力摩尔定律供给。人工智能的三大支撑是硬件、算法和数据,其中硬件指的是运行AI 算法的芯片与相对应的计算平台1。在硬件方面,目前主要是使用GPU 并行计算神经网络,同时,FPGA 和ASIC 也具有未来异军突起潜能。目前AI 芯片按照使用场景可以分为:云端(服务器端)和终端(移动端)芯片。云端主要指公有云、私有云、数据中心等需要用到的神经网络专用服务器,终端指手机、车载、安防、音响、机器人等移动应用终端。有的厂商同时具备云端和终端芯片的设计能力。

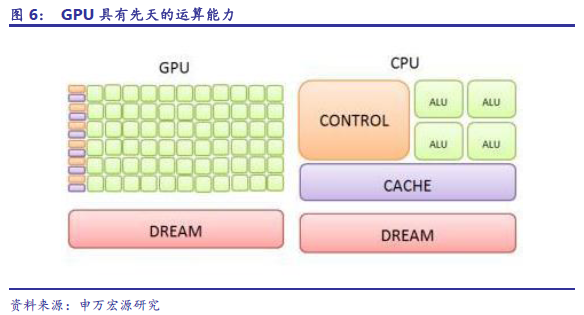

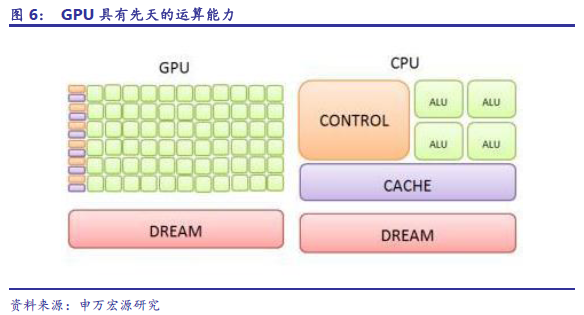

GPU 将最早受益于安防等需求爆发。GPU:图形加速起家,较成熟生态系统,最先被引入深度学习。GPU(GraphicsProcessing Unit)称为图形处理器,它是显卡的“心脏”,与CPU 类似,只不过是一种专门进行图像运算工作的微处理器。GPU 是专为执行复杂的数学和几何计算而设计的,这些计算是图形渲染所必需的。GPU 在浮点运算、并行计算等部分计算方面可以提供数十倍乃至于上百倍于CPU 的性能。英伟达公司从2006 年下半年已经开始陆续推出相关的硬件产品以及软件开发工具,目前是人工智能硬件市场的主导。GPU 对海量数据并行运算的能力与深度学习需求不谋而合,因此,被最先引入深度学习。2011 年吴恩达教授率先将其应用于谷歌大脑中便取得惊人效果,结果表明,12 颗英伟达的GPU 可以提供相当于2000颗CPU 的深度学习性能。

GPU 将最早受益于安防等需求爆发。GPU:图形加速起家,较成熟生态系统,最先被引入深度学习。GPU(GraphicsProcessing Unit)称为图形处理器,它是显卡的“心脏”,与CPU 类似,只不过是一种专门进行图像运算工作的微处理器。GPU 是专为执行复杂的数学和几何计算而设计的,这些计算是图形渲染所必需的。GPU 在浮点运算、并行计算等部分计算方面可以提供数十倍乃至于上百倍于CPU 的性能。英伟达公司从2006 年下半年已经开始陆续推出相关的硬件产品以及软件开发工具,目前是人工智能硬件市场的主导。GPU 对海量数据并行运算的能力与深度学习需求不谋而合,因此,被最先引入深度学习。2011 年吴恩达教授率先将其应用于谷歌大脑中便取得惊人效果,结果表明,12 颗英伟达的GPU 可以提供相当于2000颗CPU 的深度学习性能。

FPGA:能效居中的中间方案。FPGA:能效中等、灵活度高、成本较高的AI 白板。FPGA(Field-ProgrammableGate Array)称为现场可编程门阵列,用户可以根据自身的需求进行重复编程。FPGA 比GPU 具有更低的功耗,比ASIC 具有更短的开发时间和更低的成本。自Xilinx 在1984 年创造出FPGA 以来,在通信、医疗、工控和安防等领域占有一席之地,在过去几年也有极高的增长率。而进入了最近两年,由于云计算、高性能计算和人工智能的繁荣,拥有先天优势的FPGA 的关注度更是到达了前所未有的高度。

FPGA:能效居中的中间方案。FPGA:能效中等、灵活度高、成本较高的AI 白板。FPGA(Field-ProgrammableGate Array)称为现场可编程门阵列,用户可以根据自身的需求进行重复编程。FPGA 比GPU 具有更低的功耗,比ASIC 具有更短的开发时间和更低的成本。自Xilinx 在1984 年创造出FPGA 以来,在通信、医疗、工控和安防等领域占有一席之地,在过去几年也有极高的增长率。而进入了最近两年,由于云计算、高性能计算和人工智能的繁荣,拥有先天优势的FPGA 的关注度更是到达了前所未有的高度。

GPU 将最早受益于安防等需求爆发。GPU:图形加速起家,较成熟生态系统,最先被引入深度学习。GPU(GraphicsProcessing Unit)称为图形处理器,它是显卡的“心脏”,与CPU 类似,只不过是一种专门进行图像运算工作的微处理器。GPU 是专为执行复杂的数学和几何计算而设计的,这些计算是图形渲染所必需的。GPU 在浮点运算、并行计算等部分计算方面可以提供数十倍乃至于上百倍于CPU 的性能。英伟达公司从2006 年下半年已经开始陆续推出相关的硬件产品以及软件开发工具,目前是人工智能硬件市场的主导。GPU 对海量数据并行运算的能力与深度学习需求不谋而合,因此,被最先引入深度学习。2011 年吴恩达教授率先将其应用于谷歌大脑中便取得惊人效果,结果表明,12 颗英伟达的GPU 可以提供相当于2000颗CPU 的深度学习性能。

GPU 将最早受益于安防等需求爆发。GPU:图形加速起家,较成熟生态系统,最先被引入深度学习。GPU(GraphicsProcessing Unit)称为图形处理器,它是显卡的“心脏”,与CPU 类似,只不过是一种专门进行图像运算工作的微处理器。GPU 是专为执行复杂的数学和几何计算而设计的,这些计算是图形渲染所必需的。GPU 在浮点运算、并行计算等部分计算方面可以提供数十倍乃至于上百倍于CPU 的性能。英伟达公司从2006 年下半年已经开始陆续推出相关的硬件产品以及软件开发工具,目前是人工智能硬件市场的主导。GPU 对海量数据并行运算的能力与深度学习需求不谋而合,因此,被最先引入深度学习。2011 年吴恩达教授率先将其应用于谷歌大脑中便取得惊人效果,结果表明,12 颗英伟达的GPU 可以提供相当于2000颗CPU 的深度学习性能。

FPGA:能效居中的中间方案。FPGA:能效中等、灵活度高、成本较高的AI 白板。FPGA(Field-ProgrammableGate Array)称为现场可编程门阵列,用户可以根据自身的需求进行重复编程。FPGA 比GPU 具有更低的功耗,比ASIC 具有更短的开发时间和更低的成本。自Xilinx 在1984 年创造出FPGA 以来,在通信、医疗、工控和安防等领域占有一席之地,在过去几年也有极高的增长率。而进入了最近两年,由于云计算、高性能计算和人工智能的繁荣,拥有先天优势的FPGA 的关注度更是到达了前所未有的高度。

FPGA:能效居中的中间方案。FPGA:能效中等、灵活度高、成本较高的AI 白板。FPGA(Field-ProgrammableGate Array)称为现场可编程门阵列,用户可以根据自身的需求进行重复编程。FPGA 比GPU 具有更低的功耗,比ASIC 具有更短的开发时间和更低的成本。自Xilinx 在1984 年创造出FPGA 以来,在通信、医疗、工控和安防等领域占有一席之地,在过去几年也有极高的增长率。而进入了最近两年,由于云计算、高性能计算和人工智能的繁荣,拥有先天优势的FPGA 的关注度更是到达了前所未有的高度。