【行业】小样本学习:类人智能算法加速AI普惠化(41页)

深度学习是一种数据建模的隐含分布的多层表达机器学习算法。简单来说,就是自动提取分类中所需要的多层次(高、低)的特征集。因此,深度学习能够更好的表达数据的特征。同时,由于模型的层次、参数很多,深度学习能够对大规模数据进行学习表达,比如在图像、语音等特征不明显的领域,可以在大规模训练数据的基础上取得很好的学习效果。 深度学习可以借助类人脑网状结构的神经网络,解决很多实际问题。例如:图像搜索,人脸识别,实时翻译和语言识别等等。而强化学习则进一步推动深度学习,比如游戏,可以通过强化学习,自我竞赛,实现自我进化。近几年,大型语言模型取得了巨大进步。 2019 年,OpenAI 的 GPT2 成为第一个拥有超过 10 亿个参数的模型;2020 年,GPT3 风靡 AI 社区,它拥有 1750 亿个参数;2021 年,谷歌 SwitchTransformer 模型(1.6 万亿参数)和北京智源研究院“悟道”(1.75 万亿参数)模型打破万亿参数规模。未来,大型语言模型的规模肯定还将继续增长,比如:OpenAI的 GPT4(ChatGPT 是 GPT3.5)。

深度学习可以借助类人脑网状结构的神经网络,解决很多实际问题。例如:图像搜索,人脸识别,实时翻译和语言识别等等。而强化学习则进一步推动深度学习,比如游戏,可以通过强化学习,自我竞赛,实现自我进化。近几年,大型语言模型取得了巨大进步。 2019 年,OpenAI 的 GPT2 成为第一个拥有超过 10 亿个参数的模型;2020 年,GPT3 风靡 AI 社区,它拥有 1750 亿个参数;2021 年,谷歌 SwitchTransformer 模型(1.6 万亿参数)和北京智源研究院“悟道”(1.75 万亿参数)模型打破万亿参数规模。未来,大型语言模型的规模肯定还将继续增长,比如:OpenAI的 GPT4(ChatGPT 是 GPT3.5)。 深度学习确实对人工智能起到了巨大的推动作用,但同时,其也存在着天生的缺陷。一直以来,人工智能都依赖大量的数据进行模型训练,但这带来了过度收集个人数据、数据标注工作量大,数据领域存在“数据孤岛”等问题。 深度学习是基于大数据,通过多层网络实现对“抽象概念”的理解,数据越多其效果相应就越好。而对于人类来说,推理是一项天生技能,只需要从少量数据样本中学习,利用特征+推理的方法往往就可以进行有效的判别,这就是人类举一反三的能力,即便没有过去的知识积累,专业知识欠缺,也有 “照猫画虎”的可能性。从这个角度来说,以深度学习为核心的人工智能还远远不及人类,人类面对陌生环境依然能够通过学习做出适应变化。因此,“类人智能学习”首先要解决深度学习的这种弊端,即不依赖大数据也能进行自我学习。

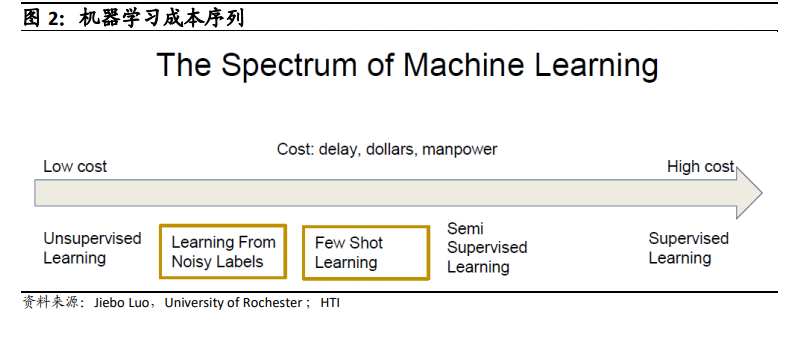

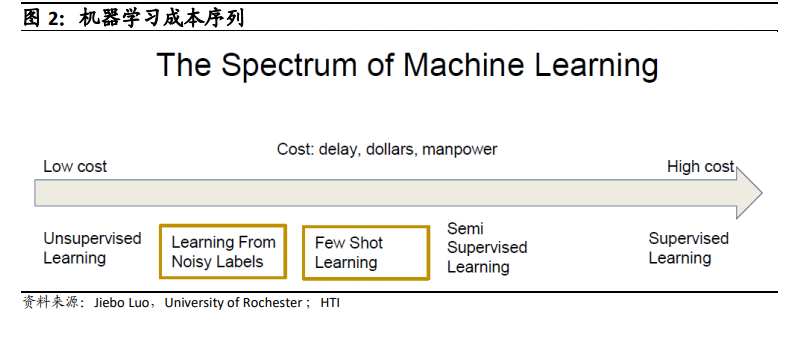

深度学习确实对人工智能起到了巨大的推动作用,但同时,其也存在着天生的缺陷。一直以来,人工智能都依赖大量的数据进行模型训练,但这带来了过度收集个人数据、数据标注工作量大,数据领域存在“数据孤岛”等问题。 深度学习是基于大数据,通过多层网络实现对“抽象概念”的理解,数据越多其效果相应就越好。而对于人类来说,推理是一项天生技能,只需要从少量数据样本中学习,利用特征+推理的方法往往就可以进行有效的判别,这就是人类举一反三的能力,即便没有过去的知识积累,专业知识欠缺,也有 “照猫画虎”的可能性。从这个角度来说,以深度学习为核心的人工智能还远远不及人类,人类面对陌生环境依然能够通过学习做出适应变化。因此,“类人智能学习”首先要解决深度学习的这种弊端,即不依赖大数据也能进行自我学习。

深度学习可以借助类人脑网状结构的神经网络,解决很多实际问题。例如:图像搜索,人脸识别,实时翻译和语言识别等等。而强化学习则进一步推动深度学习,比如游戏,可以通过强化学习,自我竞赛,实现自我进化。近几年,大型语言模型取得了巨大进步。 2019 年,OpenAI 的 GPT2 成为第一个拥有超过 10 亿个参数的模型;2020 年,GPT3 风靡 AI 社区,它拥有 1750 亿个参数;2021 年,谷歌 SwitchTransformer 模型(1.6 万亿参数)和北京智源研究院“悟道”(1.75 万亿参数)模型打破万亿参数规模。未来,大型语言模型的规模肯定还将继续增长,比如:OpenAI的 GPT4(ChatGPT 是 GPT3.5)。

深度学习可以借助类人脑网状结构的神经网络,解决很多实际问题。例如:图像搜索,人脸识别,实时翻译和语言识别等等。而强化学习则进一步推动深度学习,比如游戏,可以通过强化学习,自我竞赛,实现自我进化。近几年,大型语言模型取得了巨大进步。 2019 年,OpenAI 的 GPT2 成为第一个拥有超过 10 亿个参数的模型;2020 年,GPT3 风靡 AI 社区,它拥有 1750 亿个参数;2021 年,谷歌 SwitchTransformer 模型(1.6 万亿参数)和北京智源研究院“悟道”(1.75 万亿参数)模型打破万亿参数规模。未来,大型语言模型的规模肯定还将继续增长,比如:OpenAI的 GPT4(ChatGPT 是 GPT3.5)。 深度学习确实对人工智能起到了巨大的推动作用,但同时,其也存在着天生的缺陷。一直以来,人工智能都依赖大量的数据进行模型训练,但这带来了过度收集个人数据、数据标注工作量大,数据领域存在“数据孤岛”等问题。 深度学习是基于大数据,通过多层网络实现对“抽象概念”的理解,数据越多其效果相应就越好。而对于人类来说,推理是一项天生技能,只需要从少量数据样本中学习,利用特征+推理的方法往往就可以进行有效的判别,这就是人类举一反三的能力,即便没有过去的知识积累,专业知识欠缺,也有 “照猫画虎”的可能性。从这个角度来说,以深度学习为核心的人工智能还远远不及人类,人类面对陌生环境依然能够通过学习做出适应变化。因此,“类人智能学习”首先要解决深度学习的这种弊端,即不依赖大数据也能进行自我学习。

深度学习确实对人工智能起到了巨大的推动作用,但同时,其也存在着天生的缺陷。一直以来,人工智能都依赖大量的数据进行模型训练,但这带来了过度收集个人数据、数据标注工作量大,数据领域存在“数据孤岛”等问题。 深度学习是基于大数据,通过多层网络实现对“抽象概念”的理解,数据越多其效果相应就越好。而对于人类来说,推理是一项天生技能,只需要从少量数据样本中学习,利用特征+推理的方法往往就可以进行有效的判别,这就是人类举一反三的能力,即便没有过去的知识积累,专业知识欠缺,也有 “照猫画虎”的可能性。从这个角度来说,以深度学习为核心的人工智能还远远不及人类,人类面对陌生环境依然能够通过学习做出适应变化。因此,“类人智能学习”首先要解决深度学习的这种弊端,即不依赖大数据也能进行自我学习。